不久前,一张马斯克婴儿时期的照片在外网被疯狂转发。

你别说,这照片乍一看,还真挺容易被唬过去的。

自打这 AI 大模型成熟以后,各种 AI 生成的内容就在网络上迅速泛滥。

像什么川建国同志退休后的生活:

还有 “ 马斯克投资 AI 失败,卖烧烤还债 ”“ 马斯克在广州城中村摆摊的日子 ”“ 马斯克 kiss 女机器人 ” 。

各种梗图层出不穷,开局一张图,内容全靠编的情况是愈演愈烈。

在文本领域,不少学生借着 AI 写论文、写作业,甚至于莫言也坦言,给余华的颁奖词是 ChatGPT 帮忙写的。

那么问题来了, AI 生成的内容满天飞,我们要怎么去区分到底哪些是 AI 创作的,哪些是人类创作的呢?

前段时间 AI 诈骗 430 万的案子大家都还心有余悸,再这么任由 AI“ 狂飙 ” 下去,下一个受害者可能很快就会出现。

其实吧,现在市面上也出现了不少反 AI 工具,专门用来检测 AI 生成的内容。

不过,这些工具真的就靠谱吗?

为此,世超专门找了几个检测工具,测试了一波。

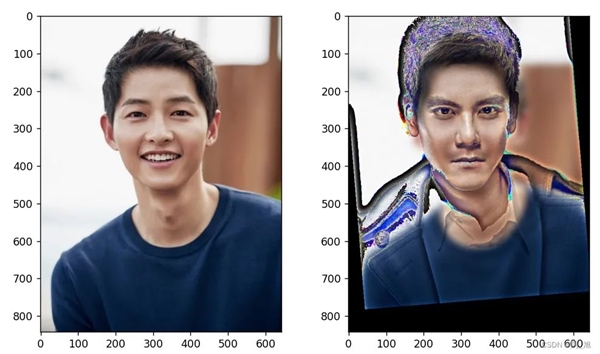

首先是 AI 图像检测。

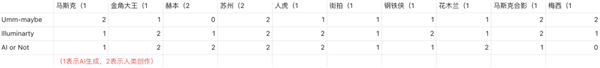

其中 Illuminarty 和 Umm-maybe 测试结果显示的是概率, AI or Not 则是直接给回答。

本以为 AI 检测工具是个 “ 火眼金睛 ” ,但没想到在马斯克 “ 返老还童 ” 的那张图片上,就开始翻车了。

Illuminarty 和 AI or Not 的态度都很明确,这明显就是由 AI 生成的。

但轮到 Umm-maybe ,画风就变了。

我寻思这肉眼都能瞧出来是 AI 干的好事,这怎么还能检测不出来呢。

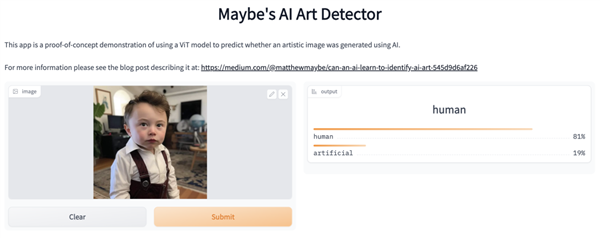

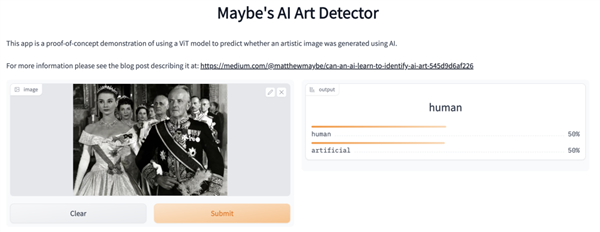

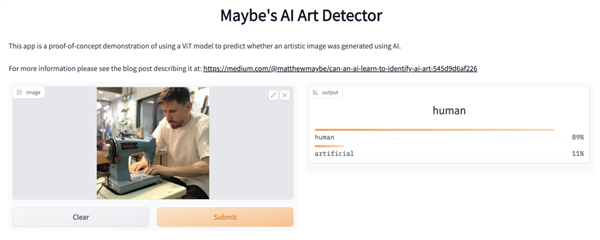

为了看看是不是偶尔的 bug ,我又多试了几次。

这张奥黛丽赫本在《 罗马假日 》里的电影截图, Umm-maybe 给了个模棱两可的答案,概率是一半一半。

剩下的一个站 AI ,一个站人类。

至少从马斯克和赫本这两张图片的测试结果来看,除了 AI or Not 之外,其他两个 AI 检测工具的判定都不太准确。

不过,打脸的时刻总是来得很快。

当我以为 AI or Not 稍微靠点儿谱的时候,它却说这张金角大王拿着汉堡的 AI 图片,是人类生成的。

你以为这就完了?更离谱的还在后头。

这有点过于荒谬了。

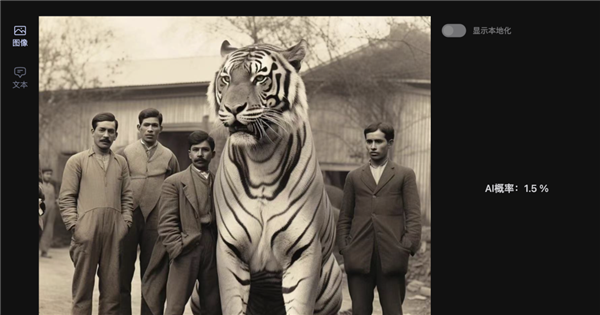

还有这张人跟巨型老虎合影的照片,肉眼就能看出来是 AI 生成的吧。

结果除了 Umm-maybe ,其余都认为这是人类创作的,甚至 Illuminarty 还觉得 AI 生成的概率只有 1.5% 。

总结一下,在 AI 图片的检测上,总共测试了 10 张不同的图片, 8 张由 AI 生成, 2 张由人类创作。

排除掉了 2 项有争议的结果后, AI or Not 和 Umm-maybe 的准确率都是 67% ,而 Illuminarty 的准确率为 50% 。

也就是说,这三个 AI 图像检测工具的准确度并不算高。

咱们再来看看文本的检测情况。

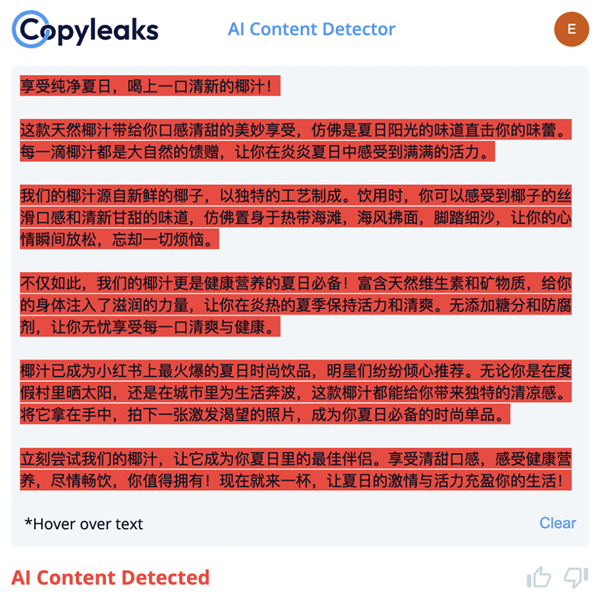

同样,还是选用了 3 个比较热门的检测工具:GPTZero 、 Sapling 以及 Copyleaks 。

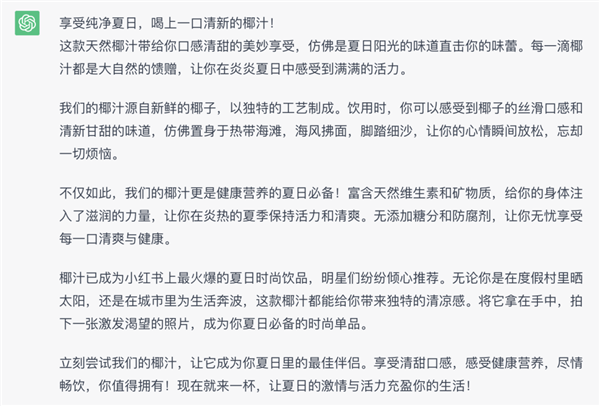

世超先让 ChatGPT 生成了一段关于椰汁的广告文案,再依次用工具进行测试。

但一上来就给我整不会了。

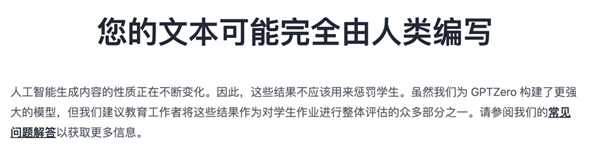

我原封不动从 ChatGPT 那边粘贴过来的文案, GPTZero 竟然说是可能完全由人类编写。

而 Sapling 给出结果也一样,这段文字由 AI 生成的概率为 0 。

只有 Copyleaks ,把全文都标红了,咬死这是 AI 写的。

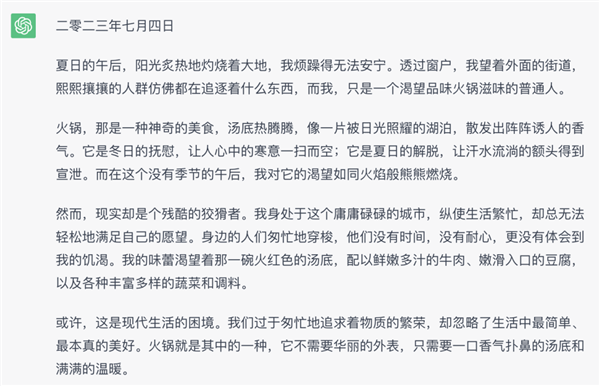

不信邪的我,又让 ChatGPT 以鲁迅的风格写了一篇《 火锅日记 》。

Copyleaks 依旧稳定发挥, GPTZero 这回倒是学聪明了,只有 Sapling 还在死死坚持那就是人写的。

为了测试这些工具对于人类创作的反应,我又节选了一段《 活着 》里的内容。

可能是余华老师的《 活着 》过于出名,几个工具在这一关上倒是没有踩坑。

其实吧,无论是图像还是文字检测,都是靠着 AI 把人类创作和机器生成区分出来。

换句话说,就是用魔法来打败魔法。

只是不同的训练模型,所用的数据集不同,分类的指标也不同。

不过,这次的测试结果大家应该也看到了, AI 检测工具的效果并没有想象中那么好。

问题可能就出在这训练数据上。

像上文提到的 AI or Not ,它的数据集范围就只有 Stable Diffusion 、 Midjourney 、 Dall-E 、 GAN 和 Generated faces 生成的图像,如果超出了这个范围,误判也是常有的事儿。

虽然可以利用视觉算法,将输入图像的分辨率、清晰度等局部细节跟 AI 图像的特征进行比对。

这文本呢,也是类似的情况。

就比如说这 GPTZero ,要想知道文字到底是不是由 AI 生成的,需要看两个指标,一个叫困惑度,一个叫突发性。

而突发性,指的就是句子结构的变化程度。

毕竟人类跟 AI 不同,在写东西的时候句式可能一会儿长一会儿短,追求的就是一个变化多端, AI 则更倾向于使用统一的句式。

但 AI 在不断的进化中,无论是在困惑性还是突发性上,生成的内容越来越接近人类。更何况现在的 AI 大模型一天一个样,等 AI 检测追上来, AI 生成的内容早不知道飙到哪去了。

但凡人类有什么风吹草动, AI 就马上能内化到自己的模型里。

照这么下去, AI 生成的东西只会越来越难以辨别。

所以眼下,咱们能做的就是寄希望于技术大牛们,赶紧想办法让 AI 检测工具实现 “ 弯道超车 ” 。